高通AI Engine Direct SDK

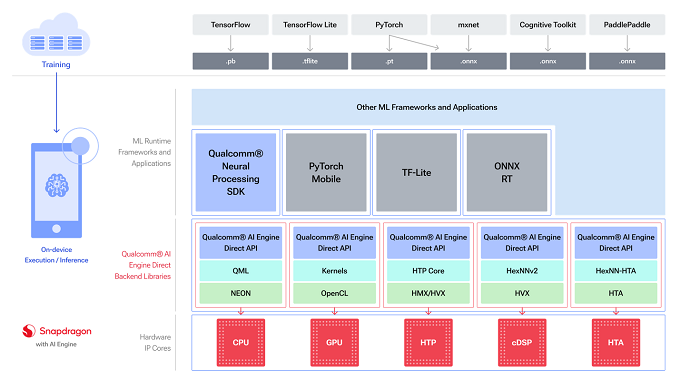

高通®AI Engine Direct SDK为AI开发提供了较低级别的统一API。

开发人员可以在高通®AI加速器上进一步接近芯片(包括高通®Kryo™ CPU,高通®Adreno™ GPU和高通®Hexagon™ 处理器等)并提高其AI模型的性能。

他们可以使用SDK来定位特定的加速器,也可以委托TensorFlow Lite或ONNX运行时的工作负载直接访问我们的Hexagon处理器。

HTP:融合AI加速器架构的Hexagon处理器

cDSP:无融合AI加速器架构的Hexagon处理器

HTA:传统的独立张量加速器

特征

高通AI Engine Direct允许在软件中为不同的硬件核心进行清晰的分离。该SDK允许开发人员将高通AI Engine Direct视为硬件抽象API,并在这些硬件核心之间移植应用程序。API提供了正确级别的抽象和处理能力,例如内部的图形优化,同时将更广泛的功能(如模型解析和网络分区)留给更高级别的框架。

开发人员可以在特定于核心的后端库提供的功能与库大小和内存利用率的成本之间进行权衡。由此产生的编译结果是一个高性能、灵活的可执行文件,在提供最高性能的同时占用最少的内存。

结构

该体系结构旨在提供模块化、可扩展、特定于加速器的库,这些库构成了全栈AI解决方案的可重用基础。并被高通技术公司(QTI)用在高通®神经处理SDK中作为第三方框架(如TensorFlow Lite和ONNX运行时)的代理。

高通AI Engine Direct架构提供了主要组件——工具、设备、后端、上下文、图形、操作包注册表——用于在最适合的核心上构建、优化和执行网络模型。

开始

高通AI Engine Direct SDK现在可以下载了。快来了解如何在骁龙®处理器上运行全栈AI解决方案并使用其统一API和核心特定库。了解更多有关信息,请访问高通®AI堆栈。

骁龙和高通公司品牌产品是高通技术有限公司和/或其子公司的产品。

Qualcomm 开发者专区是 Qualcomm 联合CSDN 共同打造的面向中国开发者的技术专区。致力于通过提供全球最新资讯和最多元的技术资源及支持,为开发者们打造全面一流的开发环境。本专区将以嵌入式、物联网、游戏开发、Qualcomm® 骁龙™处理器的软件优化等技术为核心,打造全面的开发者技术服务社区,为下一代高性能体验和设计带来更多的想法和灵感。

加入 Qualcomm 开发者专区

申请成为“Qualcomm荣誉技术大使”

“Qualcomm荣誉技术大使”是Qualcomm开发者社区对开发者用户技术能力与影响力的认证体现,该荣誉代表Qualcomm社区对用户贡献的认可与肯定。

立即申请招贤纳士

Qualcomm在中国的业务发展迅速,每年提供大量的技术岗位,分布在北京,上海,深圳等地。Qualcomm开发者社区是开发者藏龙卧虎之地,Qualcomm中国HR特别设立了招聘通道,欢迎开发者同学踊跃报名。